In einem Blogbeitrag erklärte Apple, dass es Kryptografieanwendungen über iOS und iPadOS verwenden wird, um bekannte CSAM-Bilder abzugleichen, die auf iCloud Photo gespeichert sind.

In einem Blogbeitrag erklärte Apple, dass es Kryptografieanwendungen über iOS und iPadOS verwenden wird, um bekannte CSAM-Bilder abzugleichen, die auf iCloud Photo gespeichert sind.

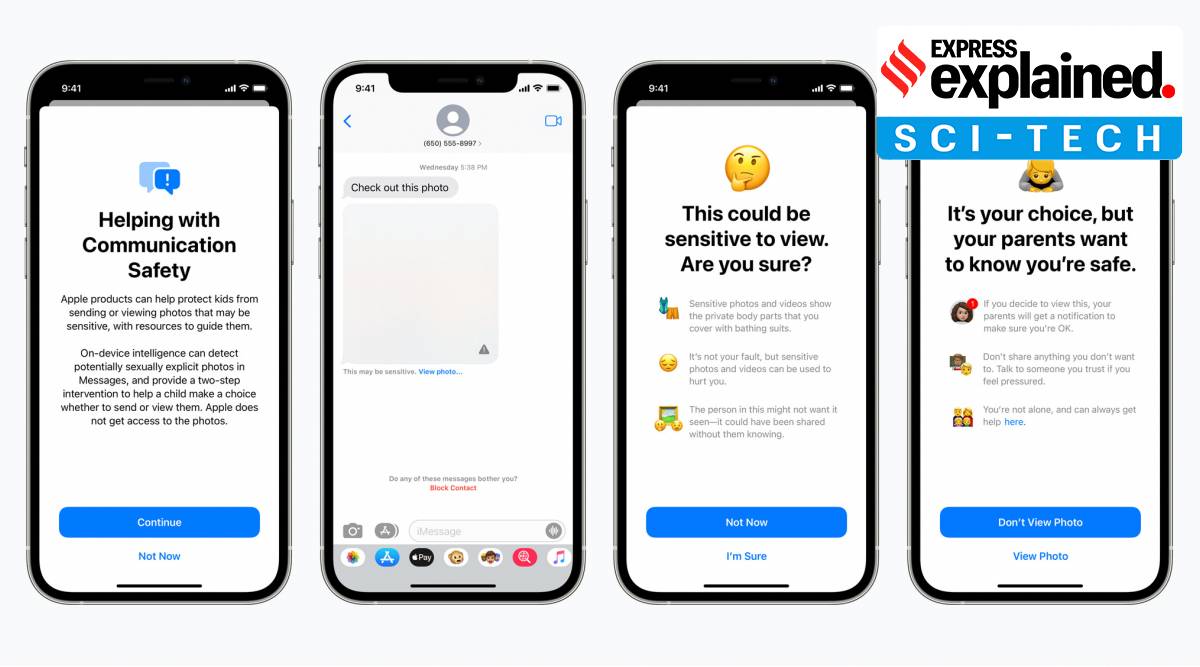

Apple hat angekündigt, dass Software-Updates im Laufe dieses Jahres neue Funktionen bieten, die “Kinder vor Raubtieren schützen, die sie mit Kommunikationsmitteln rekrutieren und ausbeuten, und die Verbreitung von Material über sexuellen Missbrauch von Kindern begrenzen”. (CSAM)“.

Zunächst in den USA geplant, beinhalten die Funktionen den Einsatz neuer Technologien, um die Verbreitung von CSAM online zu begrenzen, insbesondere über die Apple-Plattform.

Best of Explained< ul class="pdsc-related-list">

Klicken Sie hier für mehr

Dann wird es einen Schutz auf dem Gerät für Kinder geben, oder Empfang sensibler Inhalte, mit Mechanismen, um Eltern zu benachrichtigen, falls der Benutzer unter 13 Jahre alt ist. Apple greift auch ein, wenn Siri oder die Suche verwendet werden, um CSAM-bezogene Themen zu suchen.

https://images.indianexpress.com/2020/08/1×1.png

Welche Technologie unternimmt Apple, um die Verbreitung von CSAM online zu verhindern?

In einem Blogbeitrag erklärte Apple, dass es Kryptografieanwendungen über iOS und iPadOS verwenden wird, um bekannte CSAM-Bilder abzugleichen, die auf iCloud Photo gespeichert sind. Die Technologie gleicht Bilder in der iCloud eines Benutzers mit bekannten Bildern von Kinderschutzorganisationen ab. Und dies geschieht, ohne das Bild tatsächlich zu sehen, und nur durch die Suche nach einer Art Fingerabdruck-Übereinstimmung. Falls Übereinstimmungen einen Schwellenwert überschreiten, wird Apple „diese Fälle an das National Center for Missing and Exploited Children (NCMEC) melden“.

Apple stellte klar, dass seine Technologie die Privatsphäre der Benutzer berücksichtigt, und daher wird die Datenbank in „einen unlesbaren Satz von Hashes, der sicher auf den Geräten der Benutzer gespeichert wird“ umgewandelt. Es fügte hinzu, dass das Betriebssystem, bevor ein Bild in iCloud hochgeladen wird, es mit den bekannten CSAM-Hashes abgleicht, indem es eine „kryptografische Technologie namens Private Set Kreuzung“ verwendet. Diese Technologie bestimmt auch eine Übereinstimmung, ohne das Ergebnis preiszugeben.

An dieser Stelle erstellt das Gerät einen „kryptografischen Sicherheitsgutschein“ mit dem Spielergebnis und weiteren verschlüsselten Daten und speichert diesen mit dem Bild in iClouds. Die Threshold Secret Sharing-Technologie stellt sicher, dass diese Gutscheine von Apple nicht interpretiert werden können, es sei denn, das iCloud Photos-Konto überschreitet einen Schwellenwert bekannter CSAM-Inhalte. Dieser Schwellenwert, so behauptete das Blog, wurde eingeführt, um “ein extrem hohes Maß an Genauigkeit zu bieten und eine Chance von weniger als einer zu einer Billion pro Jahr zu gewährleisten, ein bestimmtes Konto falsch zu kennzeichnen”. Daher ist es unwahrscheinlich, dass ein einzelnes Bild eine Warnung auslöst.

Wird der Schwellenwert jedoch überschritten, kann Apple den Inhalt der Sicherheitsgutscheine interpretieren und jeden Bericht manuell auf Übereinstimmung überprüfen, das Konto des Benutzers deaktivieren und einen Bericht an NCMEC senden. Laut Apple können Benutzer Einspruch einlegen, wenn sie der Meinung sind, dass sie fälschlicherweise gekennzeichnet wurden.

Wie funktionieren die anderen Funktionen?

Apples neue Kommunikationssicherheit für Nachrichten wird ein sensibles Bild verwischen und ein Kind vor der Art des Inhalts warnen. Wenn dies im Backend aktiviert ist, kann dem Kind auch mitgeteilt werden, dass seine Eltern über die von ihm angezeigte Nachricht benachrichtigt wurden. Dasselbe gilt, wenn das Kind beschließt, eine sensible Nachricht zu senden. Apple sagte, dass Messages „maschinelles Lernen auf dem Gerät verwenden wird, um Bildanhänge zu analysieren und festzustellen, ob ein Foto sexuell eindeutig ist“ und dass Apple keinen Zugriff auf die Nachrichten erhält. Die Funktion wird als Update für Konten bereitgestellt, die als Familien in iCloud für die neuesten Betriebssystemversionen eingerichtet wurden.

Wenn ein Benutzer versucht, potenzielle CSAM-Themen nachzuschlagen, werden Siri und Search mit dem Update außerdem erklären, warum dies schädlich und problematisch sein könnte. Benutzer erhalten außerdem eine Anleitung, wie sie auf Anfrage eine Meldung über die Ausbeutung von Kindern einreichen können.

Auch in Erklärt |Wie manche Leute vorgeben können, ein Jahr lang auf dem Mars zu leben

Warum macht Apple? dies und welche Bedenken werden geäußert?

Große Technologieunternehmen stehen seit Jahren unter Druck, gegen die Nutzung ihrer Plattform zur Ausbeutung von Kindern vorzugehen. Viele Berichte haben im Laufe der Jahre unterstrichen, dass nicht genug getan wurde, um die Technologie daran zu hindern, CSAM-Inhalte breiter verfügbar zu machen.

Die Ankündigung von Apple ist jedoch auf Kritik gestoßen, und viele unterstreichen, dass dies genau die Art von Überwachungstechnologie ist, die viele Regierungen haben möchten und gerne missbrauchen. Die Tatsache, dass dies von Apple stammt, das seit langem der Datenschutzbeauftragte ist, hat viele überrascht.

Kryptographie-Experten wie Matthew Green von der Johns Hopkins University haben auch Befürchtungen geäußert, dass das System verwendet werden könnte, um unschuldige Personen zu rahmen, die ihnen Bilder senden, die die Spiele für CSAM auslösen sollen. “Forscher konnten dies ziemlich einfach tun”, sagte er gegenüber NPR und fügte hinzu, dass es möglich ist, solche Algorithmen zu täuschen.

Aber die New York Times zitierte Apples Chief Privy Officer Erik Neuenschwander mit den Worten, dass diese Funktionen bedeutet für normale Benutzer nichts anderes.

„Wenn Sie eine Sammlung von CSAM-Material speichern, ja, das ist schlecht für Sie“, sagte er der Veröffentlichung.

Newsletter | Klicken Sie hier, um die besten Erklärer des Tages in Ihrem Posteingang zu erhalten

Verfügen andere große Technologieunternehmen über ähnliche Technologien?

Jawohl. Tatsächlich ist Apple relativ spät in die Szene eingetreten, da Microsoft, Google und Facebook Strafverfolgungsbehörden auf CSAM-Bilder aufmerksam gemacht haben. Apple hinkte hinterher, weil eine solche Technologie gegen sein vielgepriesenes Engagement für die Privatsphäre der Benutzer verstoßen hätte. Infolgedessen konnte Apple im Jahr 2020, als Facebook dem NCMEC 20,3 Millionen CSAM-Verstöße meldete, nur 265 Fälle melden, berichtete die New York Times.

Erst jetzt konnte es die Technologie-Sweetspot, um dies zu tun, ohne normale Benutzer zu beeinträchtigen oder sie zumindest zu erschrecken. Wie die anfängliche Gegenreaktion jedoch gezeigt hat, ist es immer noch eine Gratwanderung.

- Die Indian Express-Website wurde wurde von Newsguard, einem globalen Dienst, der Nachrichtenquellen nach ihren journalistischen Standards bewertet, für seine Glaubwürdigkeit und Vertrauenswürdigkeit als GRÜN bewertet.

© IE Online Media Services Pvt GmbH