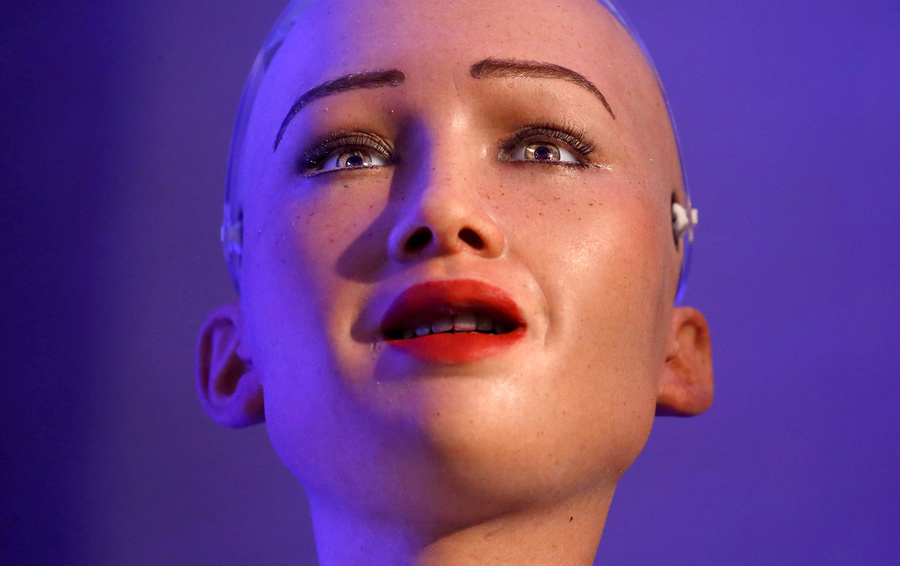

Zdjęcia Navesh Chitrakar / REUTERS

Matematycy udowodnili, że algorytmy uczenia maszynowego opierać się na problem teorii zbiorów, które nie ma rozwiązania istotnych powodów

Amir Йегудайоф z uniwersytetu w Tel-Awiwie i jego koledzy zajmowali się stosować matematycznej zadanie — algorytmy uczenia maszynowego. Nieoczekiwanie okazało się jednak, że ten problem opiera się na podstawowym matematyczny paradoks, odkryta wielkich matematyków XIX-XX w. Jerzego Кантором i Kurtem Геделем. A mianowicie pytanie o to, czy osiąga sukces algorytm uczenia maszynowego, okazał się zasadniczo rozstrzygnięcia. O tym informuje artykuł opublikowany 7 stycznia w “Nature” Machine Intelligence.

Fabuła wydania: słynne paradoksy XX wieku

Dobrym przykładem paradoksu, wykrytego matematyka Бертраном Russellem jeszcze sto lat temu, daje zadanie o dwóch katalogach. Zgodnie z jej warunkami, w bibliotece wszystkie książki muszą być dokonane w jeden z dwóch katalogów: pierwszy wprowadzane są książki, gdzie znajduje się link do samych siebie, a w drugiej — te, w których odniesienie na siebie brakuje. Ponieważ katalogi te same stanowią książki, ale także trzeba dokonać w jednym z katalogów. Jednak trudność polega na tym, że jeśli w pierwszym katalogu można zapisać link na ten sam katalog (a może i nie nagrywać — i tak nastąpi), to drugi katalog nie można nagrać nigdzie. Ale i nie zapisywać go też nie: warunek zadania będzie przeszkadzał w każdym przypadku.

Refleksje na temat расселовском paradoksie doprowadziły Kurta Геделя do sformułowania jej słynnej “twierdzenia o неполноте”. Mówił on tak: weźmy jakiś system aksjomatów matematycznych i przygotujemy pełną listę wszystkich możliwych twierdzeń matematycznych, które wynikają z tych aksjomatów (coś w rodzaju katalogu bibliotecznego). Wtedy, udowodnił Гедель, można skonstruować prawdziwe matematyczne twierdzenie, którego na pewno nie będzie w tym liście (“drugi katalog” w powyższym przykładzie). W ten sposób każdy system aksjomatów, nawet nieskończona, na pewno okaże się niekompletna: trochę prawdziwe stwierdzenie nie będzie można wycofać się z niej matematycznie. Ono będzie, jak wyrażają się matematyki, “rozstrzygnięcia” (undecidable). Ale nawet jeśli nazwać to stwierdzenie “aksjomat” i dodać do listy nowy system aksjomatów znowu okaże się niekompletna: dla niej również można skonstruować nie do udowodnienia i niepodważalne stwierdzenie.

Jeden z przykładów геделевского nierozpuszczalny stwierdzenia — “problem kontinuum”, wyrażona przez Jerzego Кантором. Niemiecki matematyk porównywałem różne niekończące się wielu i okazało się, że różnią się one od siebie “mocy”. W szczególności, wielu naturalnych, wymiernych i liczb rzeczywistych są nieograniczone. Jednak jeśli naturalnych i wymiernych można umieścić w pasujące do siebie (moc tych zestawów jest równa), z rzeczywistymi liczbami to nie działa: jego elementy znajdują się znacznie “wirze”.

Kantor zadał pytanie: a czy wielu, których moc jest większa niż zbioru liczb naturalnych, ale mniej, niż rzeczywistych? Odpowiedź na to pytanie jest dać nie mógł, a w 1940 roku Гедель udowodnił, że to właśnie jest przykład nierozpuszczalny zatwierdzenia w ramach teorii mnogości. Można powiedzieć, że zestawy pośredniej mocy nie istnieje — i to stwierdzenie będzie częścią spójnego systemu matematycznego. Ale można argumentować, i na odwrót, i w rezultacie znów uda непротиворечивая system twierdzeń, choć różni się od pierwszej.

Angielski matematyk Alan Turing rozwinął ideę Геделя w zastosowaniu do obliczeniową algorytmów. Okazało się, że na liście “wszystkich możliwych algorytmów prowadzących do rozwiązania zadania będzie notorycznie brakować łódź, ustanawiające, czy doprowadzi do rozwiązania jakiś dowolny algorytm. Na tej podstawie nowoczesny brytyjski matematyk Roger Penrose wysunął аргументированную hipotezę, według której ludzkie myślenie zasadniczo неалгоритмизируемо. Z tej hipotezy wynika, że “sztuczna inteligencja” w ścisłym znaczeniu tego słowa, nie jest możliwa: określonej klasy zadań rozwiązanych przez ludzki mózg, być może, jest nierozwiązywalne тьюринговские algorytmy.

Istota problemu: paradoks uczenia maszynowego

W XX wieku wydawało się, że геделевские nierozpuszczalnych zatwierdzenia noszą dość abstrakcyjny charakter i nie mają nic do której zadań. Kilka lat temu, jednak grupa fizyków-teoretyków, na czele z Tonym Кьюбиттом udowodniła, że геделевская неразрешимость występuje w fizycznej zadaniu “kwantowego гэпа”: nie można wyliczyć teoretycznie, okaże się, czy dowolnie duża płyta niejakiego materiału nadprzewodnik.

Autorzy artykułu w “Nature” zajmowali się jeszcze bardziej stosowanej problemem — maszyny szkoleniem. Zwykle zadania te wyglądają tak: algorytm stawiają “nauka” skończone zbiory danych, w których wymagane jest, na przykład, nauczyć się rozpoznawać obraz kotka. Zadaniem nauki za rozwiązany, jeśli łódź będzie w stanie bezbłędnie “znalezienie kociąt” w dowolnie dużym, czyli nieskończonym, zbiorze danych.

Йегудайоф i jego koledzy badali związek między обучаемостью i “kompresji” danych. Okazało się, że pytanie o ściśliwości informacji jest ściśle związany z problemem kontinuum Kantora — która, jak wspomniano powyżej, matematycznie jest nierozwiązywalny. Istnieje nieskończenie wiele sposobów, aby wybrać spośród nieskończenie dużego zestawu danych mniejszy zestaw. Jednak “moc” tej nieskończoności pozostawała nieznana. Autorzy wskazują, że ta “moc” i charakteryzuje się неразрешимостью w ramach problemu kontinuum. A mianowicie, jeśli przyjąć hipotezę Kantora, to zawsze znajdzie się mały zestaw edukacyjnych danych, na podstawie którego łódź nauczyć się przewidywać — “szukać kotka” — w dowolnie dużej próby. Ale jeśli przyjąć twierdzenie odwrotne, czyli dopuścić istnienie zbiorów pośredniej mocy, żadna próbka danych nie daje gwarancji sukcesu.

Zdaniem autorów pracy, odkryta paradoks jest bardzo ważne dla zrozumienia zasad kompresji danych, zawartych w podstawach uczenia maszynowego. W tym samym czasie jego praktyczne znaczenie pozostaje pod znakiem zapytania: kompletne zestawy danych stanowią abstrakcję matematyczną. Jednak takie badania, które wskazują na fundamentalne granice algorytmicznego “myślenia”, są bardzo ważne dla zrozumienia perspektyw rozwoju systemów sztucznej inteligencji, a w końcu — dla zrozumienia fenomenu ludzkiego umysłu.