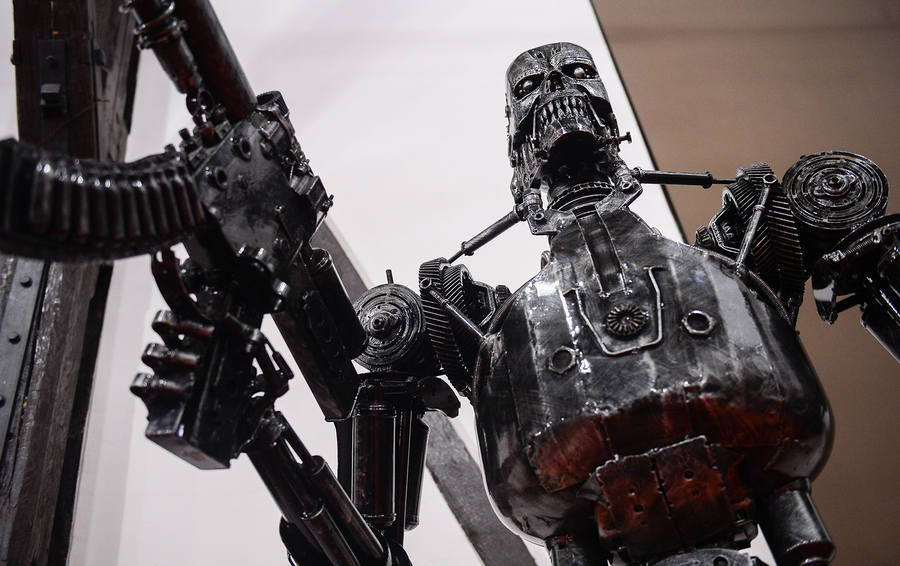

Zdjęcia SOPA Images / Getty Images

Wkrótce technologii pozwolą stworzyć broń automatyczną, która będzie mogła wybierać i decydować o niszczeniu celów niezależnie od człowieka. I podczas gdy wszyscy kłócą się, jak to etyczne, postęp nieubłaganie do przodu

Podczas gdy premier Dmitrij Miedwiediew i Szczepan Волож jeździli na беспилотном “Yandex.Taxi” na “Skołkowo”, wojskowi inżynierowie zastanawiali się, jak dostosować technologii bezzałogowego transportu do tworzenia nowych broni.

W rzeczywistości, technologia nie jest do końca tym, czym wydają się być. Problem całej technologicznej ewolucji w tym, że granica między komercyjnymi roboty “dla życia” i wojskowymi robotami-zabójcami niezwykle cienka, i przejść ją nic nie kosztuje. Póki co wybierają trasę ruchu, a jutro będą mogli sami wybrać, której celem jest zniszczyć.

Nie jest to pierwszy raz w historii, kiedy postęp technologiczny stawia pod znakiem zapytania samo istnienie ludzkości: najpierw naukowcy stworzyli chemicznej, biologicznej i nuklearnej, teraz — “niezależne broń”, czyli robotów. Różnica tylko w tym, że do tej pory sądzono nieludzkie broń “masowego rażenia” — czyli nie выбирающее, kogo mu zabijać. Dziś perspektywa się zmieniła: o wiele bardziej niemoralne wydaje się broń, która będzie zabijać z najwyższą zrozumiałości, wybierając ofiary na własny smak. I jeśli jakąś agresywną władzę przeszkadzało to, że, użyj ona broń biologiczna, ucierpią wszyscy wokół, to z robotami coraz trudniejsze — można je zaprogramować na zniszczenie określonej grupy obiektów.

W 1942 roku, kiedy to amerykański pisarz Isaac Asimov sformułował trzy prawa robotyki, wszystko to wydawało się ekscytujące, ale zupełnie nierealne. Przepisy te mówią, że robot nie może i nie powinien skrzywdzić lub zabić człowieka. A jeszcze muszą bezwarunkowo podporządkować się woli człowieka, z wyjątkiem tych przypadków, kiedy jego rozkazy będą sprzeczne z powyższym wymóg. Teraz, gdy niezależne broń staje się rzeczywistością i może wpaść w ręce terrorystów, okazało się, że programiści jakoś zapomnieli położyć w jego prawa Азимова. A to znaczy, że roboty mogą stanowić zagrożenie, a nie humanitarne prawa lub zasady nie będą w stanie ich zatrzymać.

Opracowany przez Pentagon rakieta sama wykrywa cele dzięki oprogramowaniu, sztuczna inteligencja (AI) identyfikuje cel dla brytyjskich wojskowych, a Rosja demonstruje bezzałogowe czołgi. Na rozwój robotów i autonomicznego sprzętu wojskowego w różnych krajach przeznacza się ogromne środki, chociaż ją zobaczyć w akcji mało komu chce. Jak większość chemików i biologów nie są zainteresowani tym, aby ich otwarcia w końcu zostały wykorzystane do stworzenia broni chemicznej lub biologicznej, jak i większość badaczy AI nie są zainteresowani w tworzeniu broni na jego podstawie, bo wtedy poważny rozgłos zaszkodzi ich programów badawczych.

W swoim przemówieniu na początku Zgromadzenia ogólnego Organizacji Narodów Zjednoczonych w Nowym Jorku 25 września sekretarz generalny António Гутерреш nazwał technologię AI “globalnym ryzykiem” wraz ze zmianą klimatu i rosnące nierówności dochodów: “nazywajmy rzeczy po imieniu — powiedział. — Perspektywa, że maszyny będą decydować, kto ma żyć — jest obrzydliwa”. Prawdopodobnie Гутерреш — jedynym, który może wezwać wojsko resortu opamiętania: wcześniej znał się z konfliktem w Libii, Jemenie i Syrii i pełnił funkcję Wysokiego komisarza do spraw uchodźców.

Problem w tym, że przy dalszym rozwoju technologii roboty sami będą mogli decydować, kogo zabijać. I jeśli w niektórych krajach takie technologie będą, a u innych nie, to bezkompromisowe androidy i drony предрешат wynik potencjalnej bitwy. Wszystko to jest sprzeczne z prawami Азимова jednocześnie. Алармисты mogą poważnie martwić się o tym, że самообучаемая sieć neuronową wymknie się spod kontroli i pobije nie tylko wroga, ale i wszystkich ludzi w ogóle. Jednak perspektywa nawet całkowicie posłusznych maszyn-zabójców, zupełnie nie радужна.

Najbardziej aktywna praca w dziedzinie sztucznej inteligencji i uczenia maszynowego na dzień dzisiejszy prowadzona jest nie w wojsku, a w cywilnym — na uniwersytetach i w firmach jak Google i Facebook. Ale większość z tych technologii może być dostosowany do militarnego wykorzystania. To znaczy, że potencjalny zakaz badania w tej dziedzinie, dotknie i cywilnych rozwoju.

Na początku października amerykańska organizacja pozarządowa “Kampania “Stop robotów-zabójców” wysłała list do Organizacji Narodów Zjednoczonych z żądaniem ograniczyć rozwój autonomicznej broni na międzynarodowym poziomie legislacyjnym. ONZ dała do zrozumienia, że popiera tę inicjatywę, a w sierpniu 2017 roku do niej dołączyli Elon Musk i uczestnicy Międzynarodowej konferencji ONZ w sprawie użycia sztucznej inteligencji (IJCAI). Ale w rzeczywistości STANY zjednoczone i Rosja sprzeciwiają się takich ograniczeń.

Ostatnie spotkanie 70 krajów członkowskich Konwencji o konkretnych rodzajach broni zwykłej (o “nieludzkie” broni) odbyła się w Genewie w sierpniu. Dyplomaci nie udało się osiągnąć konsensusu co do tego, jak globalna polityka w stosunku do AI może być zrealizowana. Niektóre kraje (Argentyna, Austria, Brazylia, Chile, Chiny, Egipt i Meksyk) wyrazili poparcie dla ustawowego zakazu rozwoju zautomatyzowanego broni, Francja i Niemcy zaproponowali wprowadzenie ochotniczej system takich ograniczeń, jednak Rosja, STANY zjednoczone, korea Południowa i Izrael oświadczyli, że nie zamierzają ograniczać badania i rozwój, które są prowadzone w tej dziedzinie. We wrześniu Federica Mogherini, wysoki przedstawiciel Unii europejskiej ds. polityki zagranicznej i bezpieczeństwa, oświadczyła, że broń “wpływa na naszą zbiorową bezpieczeństwo”, więc rozwiązanie problemu życia i śmierci, musi w każdym przypadku zostać w rękach człowieka.

Zimna wojna-2018

Urzędnicy amerykańskiej obrony uważa, że niezależne broń należy Stanom Zjednoczonym, aby utrzymać swoją przewagę wojskową przed Chinami i Rosją, które również inwestują pieniądze na podobne badania. W lutym 2018 roku Donald Trump zażądał przeznaczyć $686 mld usd na obronę kraju, w następnym roku finansowym. Koszty te zawsze były dość wysokie i spadła chyba, że po poprzednim prezydencie Baracku Obamie. Jednak Trump — неоригинально — argumentował konieczność zwiększenia konkurencji technologicznej z Rosją i Chinami. W 2016 roku w budżecie Pentagonu został założony $18 mld na rozwój autonomicznej broni w ciągu trzech lat. To niewiele, ale tu trzeba wziąć pod uwagę jeden bardzo ważny czynnik.

Większość prac rozwojowych w obszarze SI w USA prowadzone są firmami, dlatego są one dostępne publicznie i mogą być sprzedane w celach komercyjnych innych krajów. U Pentagonu nie ma monopolu na zaawansowane technologie uczenia maszynowego. Amerykański przemysł obronny nie prowadzi własne badania, tak jak to miało miejsce podczas “zimnej wojny”, a korzysta z pracy startupów z doliny Krzemowej, a także Europy i Azji. W tym samym czasie w Rosji i Chinach takie badania są pod ścisłą kontrolą resortów obronnych, co z jednej strony ogranicza napływ nowych pomysłów i rozwój technologii, ale z drugiej, gwarantuje госфинансирование i ochronę.

W ocenie ekspertów The New York Times, wydatki wojskowe na autonomiczne pojazdy wojskowe i samoloty bezzałogowe przekroczy $120 mld dolarów w ciągu następnej dekady. Oznacza to, że dyskusja w ostatecznym rachunku sprowadza się nie do tego, czy warto tworzyć niezależne broń, a do tego, jaki stopień niezależności mu dać.

Dziś w pełni autonomicznej broni nie ma, ale zastępca przewodniczącego Połączonego komitetu szefów sztabów generał Paul J. Selva z sił POWIETRZNYCH jeszcze w 2016 r. stwierdził, że przez 10 lat Stany Zjednoczone będą mieli technologię tworzenia takiej broni, która jest w stanie samodzielnie zdecydować, kogo i kiedy zabić. I aż kraju dyskutują o tym, czy warto ograniczać AI lub nie, może być za późno.

redakcja poleca

Ramię w ramię: Elon Musk i rosyjscy inżynierowie przeciwko robotów-zabójców