Nyckelalternativ

- GPT-4o är halva kostnaden och dubbelt så hög hastighet som GPT-4 Turbo, med extra multimodala möjligheter.

- GPT-4o kan tolka ickeverbala element, svara med ett känslomässigt intervall och hantera stora mängder data.

- GPT-4o är tillgänglig för gratis och betalda användare, med en högre användningsgräns för betalda användare; framtida funktioner kommer att släppas gradvis.

Framstegsmarschen för generativ AI förvandlas till mer av en sprint, och OpenAIs tillkännagivande och release av GPT-4o "Omni" lovar att ta ett steg framåt i ChatGPT och dess relaterade tjänster inom flera områden. Om du inte redan har tillgång till GPT-4o kommer du snart. Så låt oss titta på vad som skiljer den här nya AI-modellen från vad som kommit tidigare.

GPT-4o vs. GPT-4 Turbo och GPT-3.5

Vi har redan tagit upp skillnaden mellan GPT3.5 och GPT-4 Turbo i detalj, men den korta versionen är att GPT-4 är betydligt smartare än GPT-3.5. Den kan förstå mycket mer nyanser, producera mer exakta resultat och är betydligt mindre benägen för AI-hallucinationer. GPT-3.5 är fortfarande väldigt relevant eftersom det är snabbt, tillgängligt gratis och fortfarande kan hantera de flesta vardagliga uppgifter med lätthet. Så länge du är medveten om att det är mycket mer sannolikt att du får felaktig information.

GPT-4 Turbo hade varit flaggskeppsmodellen fram till ankomsten av GPT-4o. Den här modellen var endast tillgänglig för ChatGPT Plus-prenumeranter och kom med alla roliga leksaker som OpenAI utvecklat, som anpassade GPT:er och live webbåtkomst.

Innan vi går in på de faktiska funktionerna och möjligheterna är ett viktigt faktum att (enligt OpenAI) GPT-4o är halva kostnaden och dubbelt så snabb som GPT-4. Det är troligen därför GPT-4o är tillgängligt för både gratis och betalda användare, även om betalande användare kommer att få fem gånger användningsgränsen för GPT-4o.

Det är i stort sett lika smart som GPT-4 Turbo, så överlag handlar detta framsteg mer om effektivitet. Det finns dock några uppenbara och inte så uppenbara framsteg som går längre än att bara vara snabbare och billigare.

Vad kan GPT-4o göra?

Det stora modeordet med GPT-4o är “multimodal”, vilket vill säga att GPT-4o kan fungera på ljud, bilder, video och text. Tja, det kunde GPT-4 Turbo också, men den här gången är det annorlunda under huven.

strong>

OpenAI säger att det har tränat ett enda neuralt nät på alla modaliteter samtidigt. Med den äldre GPT-4 Turbo, när du använder röstläge, skulle den använda en modell för att konvertera dina talade ord till text. Sedan skulle GPT-4 tolka och svara på den texten, som sedan konverterades tillbaka till en syntetiserad AI-röst.

Med GPT-4o är allt en modell, som har många genomslagseffekter på prestanda och förmågor. OpenAI hävdar att svarstiden när man samtalar med GPT-4o nu bara är några hundra millisekunder, ungefär samma som en realtidskonversation med en annan människa. Jämför detta med de 3-5 sekunder det tog för äldre modeller att svara, och det är ett stort steg.

Förutom att det är mycket snabbare, betyder det också att GPT-4o nu också kan tolka icke-verbala element av tal, såsom tonen i din röst, och dess eget svar har nu ett känslomässigt omfång. Den kan till och med sjunga! Med andra ord har OpenAI gett GPT-4o ett visst mått av affektiv datorförmåga.

Samma typ av effektivitet och enande gäller för text och bilder, såväl som video. I en demo visas GPT-4o som har en realtidskonversation med en människa med livevideo och ljud. Precis som att ha en videochatt med en människa verkar det som att GPT-4o kan tolka vad den ser genom kameran och göra några ganska skarpa slutsatser. ChatGPT-4o kan också ha ett betydligt större antal tokens i åtanke jämfört med tidigare modeller, vilket innebär att den kan tillämpa sin intelligens på mycket längre konversationer och större mängder data. Detta kommer förmodligen att göra det mer användbart för uppgifter som att hjälpa dig att skriva en roman, som ett exempel.

Nu när detta skrivs är inte alla dessa funktioner tillgängliga för allmänheten ännu, men OpenAI har sagt att det kommer att rulla ut dem under veckorna efter det första tillkännagivandet och lanseringen av kärnmodellen.

Hur mycket kostar GPT-4o?

GPT-4o är tillgängligt för både gratis och betalda användare, även om betalande användare kommer att få fem gånger användningsgränsen för GPT-4o. När detta skrivs är kostnaden för ChatGPT Plus fortfarande $20 per månad, och om du är en väl utvecklare måste du leta upp API-kostnaderna för dina behov, men GPT-4o borde vara mycket billigare jämfört med andra modeller.

Hur man använder GPT-4o

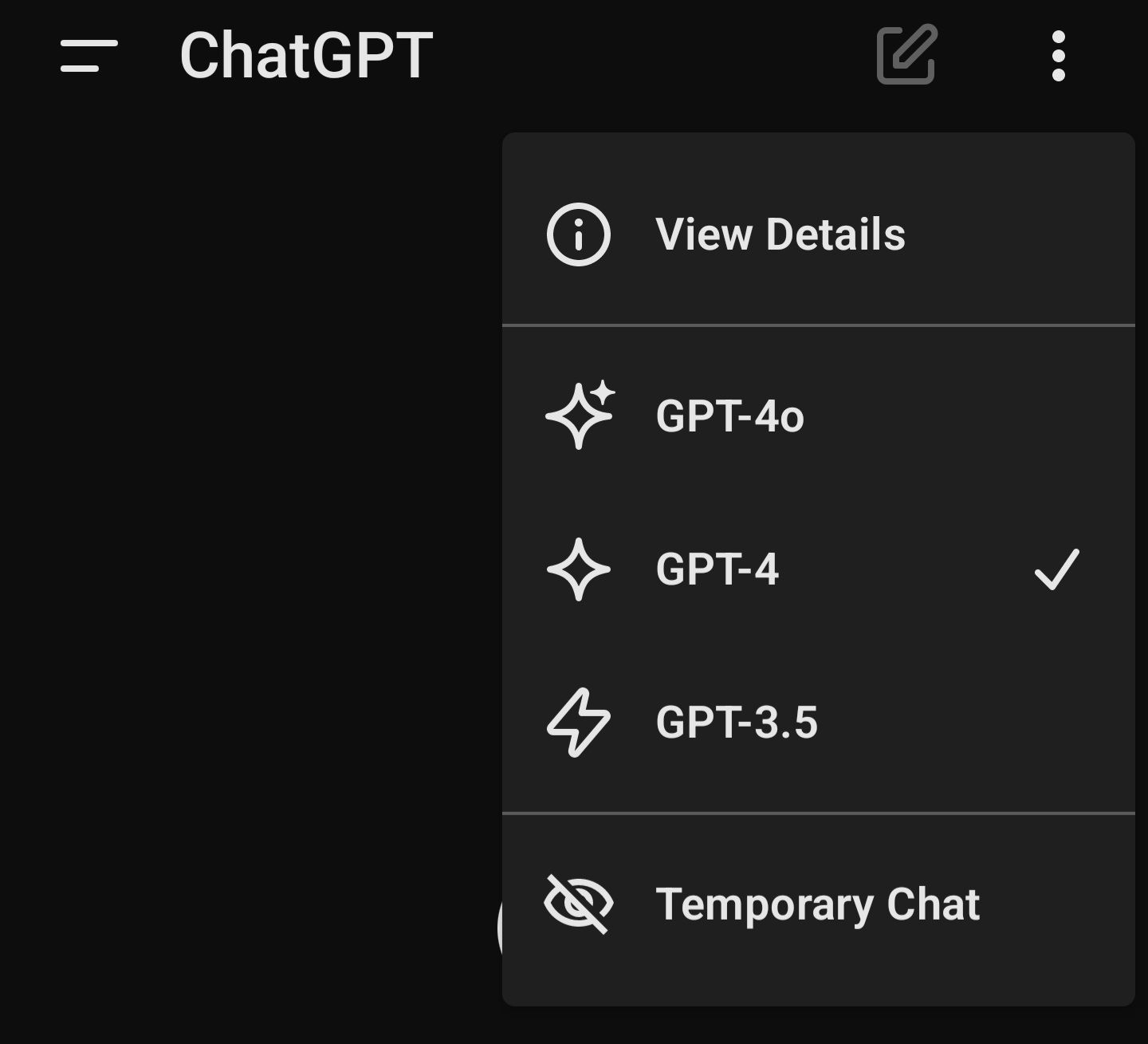

Som jag nämnde ovan är GPT-4o tillgänglig för både gratis och betalda användare, men inte alla dess funktioner är online direkt. Så, beroende på när du läser det här, kommer de exakta sakerna du kan göra med det variera. Som sagt, att använda GPT-4o är helt enkelt. Om du använder ChatGPT-webbplatsen som ChatGPT Plus-prenumerant klickar du bara på rullgardinsmenyn som visar det aktuella modellnamnet och väljer GPT-4o.

Om du är en gratis användare, kommer du att vara standardinställd på ChatGPT-4o tills du får slut på din tilldelning. Då släpps du tillbaka till version 3.5 tills du har fler förfrågningar tillgängliga.

När detta skrivs är ChatGPT-4o ännu inte tillgänglig i gratisnivån, så ovanstående är baserat på OpenAIs dokumentation. Saker och ting kan fungera lite annorlunda när funktionen rullas ut till gratisanvändare.

Om du använder mobilappen trycker du bara på de tre prickarna och väljer modell därifrån.

Använd sedan ChatGPT som du brukar!

När ChatGPT-4o släpps i sin slutgiltiga form kan vi äntligen få den bevandrade, naturliga språkassistenten som science fiction har lovat. Om det är bra eller dåligt låter jag vara helt upp till dig, men det är verkligen spännande!

Leave a Reply

You must be logged in to post a comment.