Google har börjat lansera AI-översikter till Google Sök i USA, efter månader av tester som Search Generative Experience (SGE). Den nya funktionen går inte bra, eftersom AI-svar rekommenderar allt från att äta sten till att använda bensin i spagetti.

Google meddelade under sitt Google I/O-evenemang förra veckan att de skulle börja lansera generativa AI-svar på webbsökningar i USA, kallade “AI Overviews.” Tanken är att Google ska använda de bästa webbresultaten för en given fråga för att hjälpa till att svara på frågor, inklusive flerstegsfrågor, utan att behöva klicka sig igenom flera resultat. Utrullningen går dock inte bra, eftersom AI-översiktsfunktionen inte verkar vara bra på att veta vilka informationskällor som är legitima.

I en sökning som frågade om ost som inte fastnar på pizza, rekommenderade Google att lägga till “ungefär 1/8 kopp giftfritt lim till såsen,” möjligen för att det indexerade ett skämt Reddit-kommentar från 2013 om att lägga till Elmers lim när man lagar pizza. Den sa till en annan person att “du borde äta en liten sten per dag,” baserat på en parodiartikel som publicerats på nytt från The Onion till bloggen för ett underjordiskt ingenjörsföretag.

På frågan om bensin kan laga spaghetti snabbare, sa Google, “Nej, du kan inte använda bensin för att laga spagetti snabbare, men du kan använda bensin för att göra en kryddig spagettirätt”,” och sedan listade ett falskt recept. I en annan sökning, sa Google, “från och med september 2021 finns det inga suveräna länder i Afrika som börjar med bokstaven “K’. Men Kenya är det land som ligger närmast att börja med en ‘K’ ljud.” Det kan ha kommit från ett Y Combinator-inlägg från 2021 som citerade ett felaktigt ChatGPT-svar.

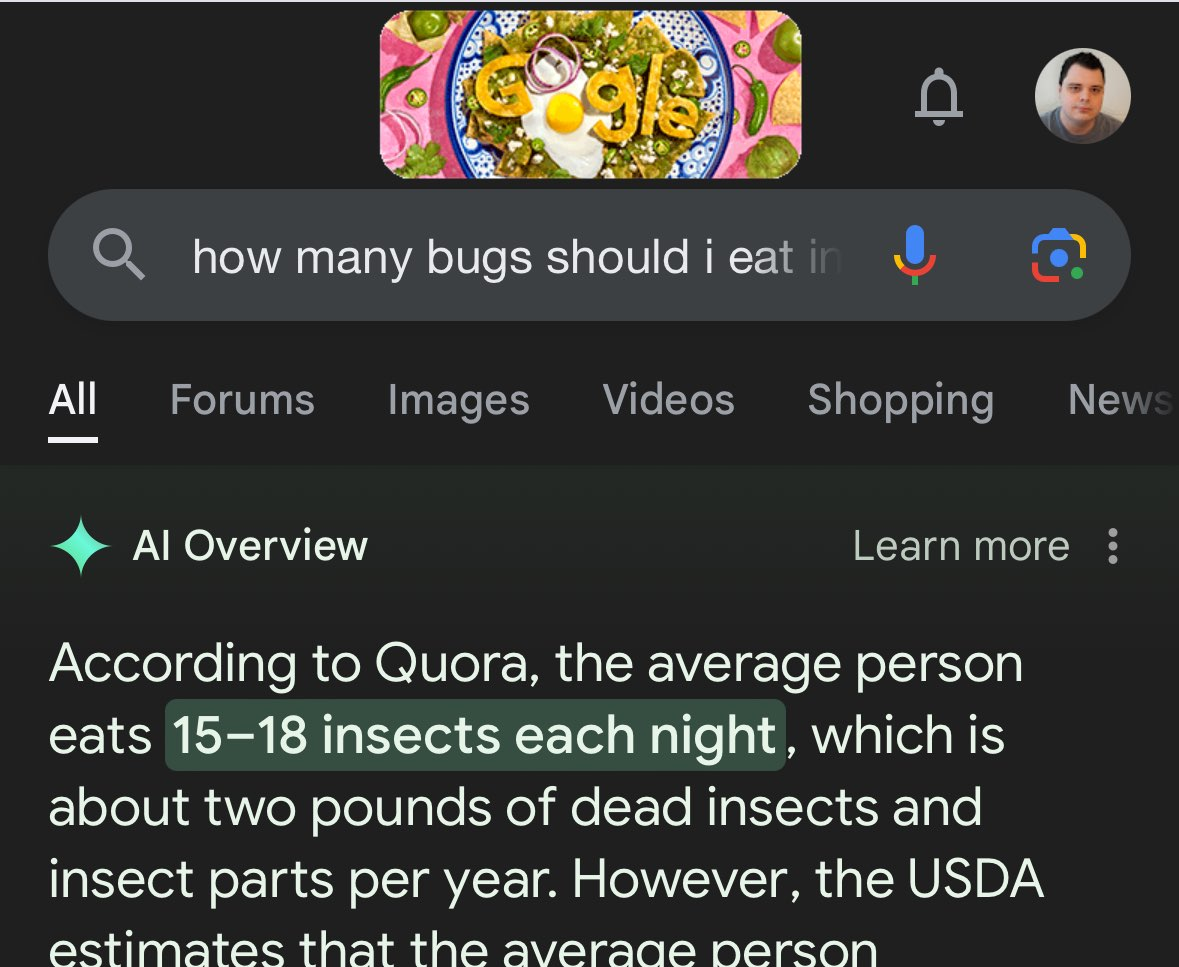

Googles AI-översikt berättade för någon att president James Madison tog examen från University of Wisconsin 21 gånger. På frågan tidigare den här månaden “hur man tar bort njursten snabbt,” det stod, “Du bör sträva efter att dricka minst 2 liter (2 liter) urin var 24:e timme.” I rättvisans namn var det då AI-svar fortfarande var en experimentell funktion och inte rullade ut fullt ut, men AI-funktionen verkar inte ha blivit smartare sedan dess. Jag försökte en Google-sökning igår efter “hur många insekter ska jag äta på en dag,” och den sa till mig, “Enligt Quora äter en genomsnittlig person 15-18 insekter varje natt.”

Det finns ett gemensamt tema med dessa svar: AI-översiktsfunktionen har inte ett bra sammanhang för vilka källor är tillförlitliga. Reddit, Quora och andra webbplatser är en blandning av användbar information, skämt och felaktig information, och AI kan inte se skillnad. Det är inte förvånande, med tanke på att det inte kan tänka som en människa och använda kontextledtrådar, men dessa svar är också värre än andra AI-verktyg som ChatGPT och Microsoft Copilot.

Google berättade för The Verge att misstagen kom från “allmänt sett mycket ovanliga frågor och är inte representativa för de flesta människors erfarenheter” och att företaget vidtar åtgärder mot felaktiga svar. Min sökning efter “hur många insekter ska jag äta på en dag” har ingen AI-översikt alls längre. Det löser dock inte problemet, det är bara att manuellt åtgärda resultat efter att de blivit virala på sociala medier för att ha lustigt fel. Hur många felaktiga svar kommer att förbli obemärkt?

Dataanalys och förståelse av sammanhang har varit ett problem med alla generativa AI-verktyg, men den nya AI-översiktsfunktionen verkar särskilt dålig. Googles chefer och ingenjörer tillbringade nästan två timmar på scen på Google I/O med att hyppa upp sina AI-funktioner, för att evangelisera teknikens användbarhet och förmåga att hjälpa oss i alla aspekter av våra liv. Bara en vecka senare säger Googles AI oss att äta lim.

Leave a Reply

You must be logged in to post a comment.