Veiliger voor kinderen

Het gaat om drie functies die op verschillende plekken in iOS, iPadOS en macOS te vinden zijn. Zo komt er een nieuw systeem om materiaal met kindermisbruik te detecteren, iets waar we vandaag al eerder over schreven. Op dat moment ging het nog om geruchten, nu heeft Apple de volledige reeks maatregelen onthuld. Op deze pagina staan ze allemaal opgesomd.

Ze moeten voorkomen dat zogenaamd CSAM (Child Sexual Abuse Material) zich verspreidt. Kinderen brengen veel tijd online door en lopen daarbij risico’s om ongeschikt materiaal onder ogen te krijgen. Tegelijk lopen kinderen het risico dat ze zelf worden vastgelegd in schokkend beeldmateriaal. Alle drie functies zijn geoptimaliseerd voor privacy. Dat houdt in dat Apple wel informatie over criminele activiteiten kan doorgeven aan de activiteiten, maar dat de privacy van brave burgers niet in het geding is.

Het scannen van iCloud Foto’s is het belangrijkste onderdeel. Als er CSAM wordt ontdekt zal het betreffende account worden voorzien van een vlaggetje. Apple zal het ook rapporteren aan een organisatie voor zoekgeraakte kinderen en zal medewerking verlenen aan wetshandhavingsinstanties in de VS. Apple benadrukt dat het voorlopig alleen in de VS gebruikt gaat worden. Mogelijk volgt er later nog een verdere uitrol.

These are bad things. I don’t particularly want to be on the side of child porn and I’m not a terrorist. But the problem is that encryption is a powerful tool that provides privacy, and you can’t really have strong privacy while also surveilling every image anyone sends.

— Matthew Green (@matthew_d_green) August 5, 2021

Apple scant de foto’s niet, maar gebruikt intelligentie op het apparaat om de CSAM te matchen met een database van reeds bekende foto’s, die zijn omgezet naar onleesbare hashes. Dit is een ingewikkeld proces waarbij gebruik wordt gemaakt van cryptografische technieken, om de privacy te garanderen.

Een verdacht account zal worden geblokkeerd na een handmatige inspectie. Gebruikers kunnen protest aantekenen als ze vinden dat hun account onterecht is afgesloten. Het geldt alleen voor iCloud Foto’s en niet voor foto’s die lokaal op het toestel staan.

Een uitgebreide technische uitleg vind je hier in PDF-formaat.

Meer veiligheid bij iMessage-gebruik

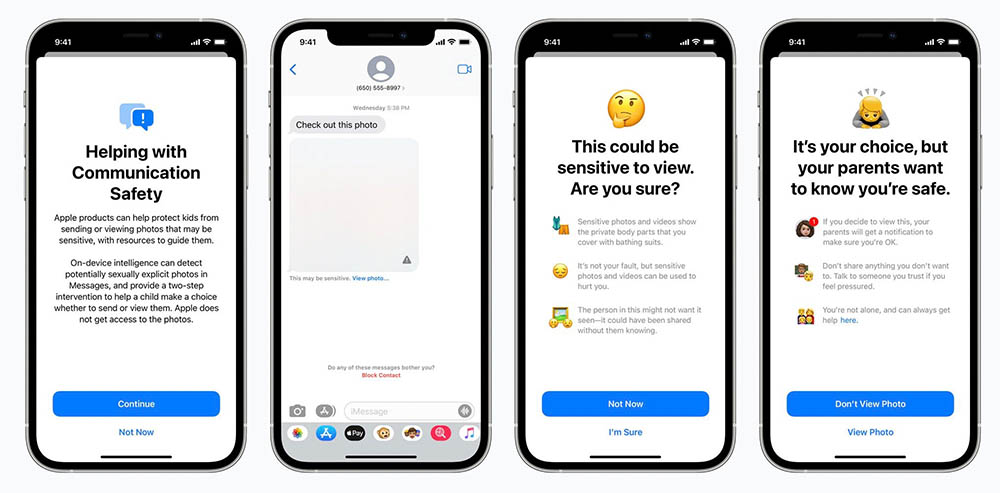

Apple gaat ook nieuwe functies invoeren om te zorgen dat ouders op de hoogte zijn hoe hun kinderen online communiceren. Als kinderen een seksueel getinte foto ontvangen, zal deze automatisch onscherp worden gemaakt en krijgen ze een waarschuwing. Willen ze de foto toch bekijken, dan zal het bericht ook aan de ouders worden doorgestuurd.

Ook hierbij wordt gebruik gemaakt van machine learning om foto’s te analyseren en te bepalen of het om expliciete beelden gaat. Apple ontvangt geen kopie van de foto.

Siri en zoeken helpen je verder

Ook Siri en zoeken worden veiliger voor gebruikers. Je kunt bijvoorbeeld Siri om hulp vragen als je met CSAM geconfronteerd wordt. Siri stuurt je dan door naar de juiste bronnen. Apple benadrukt dat er niet alleen op privacy is gelet, maar ook op mogelijk misbruik door overheden in landen waar het minder veilig is. Ook is de versleuteling niet verzwakt om deze nieuwe tools mogelijk te maken. End-to-end versleutelde foto’s kunnen niet worden geanalyseerd.

Toch zijn beveiligingsonderzoekers niet helemaal gerust. Apple baseert zich op een database met hashes die niet geraadpleegd kan worden. Blijkt een onschuldige foto dezelfde hash te hebben als een bekende CSAM, dan valt voor jou als gebruiker moeilijk te bewijzen dat het om twee heel verschillende foto’s gaat.