Auf Basis von klassischem HBM2 (ohne e) hat Samsung eine Adaption mit programmierbarer Kontrolleinheit entwickelt, die vornehmlich für AI-Beschleunigung und damit für den entsprechenden Markt gedacht ist. Dafür gibt es auf der einen Seite große Boni, auf der anderen Seite müssen aber Kompromisse eingegangen werden.

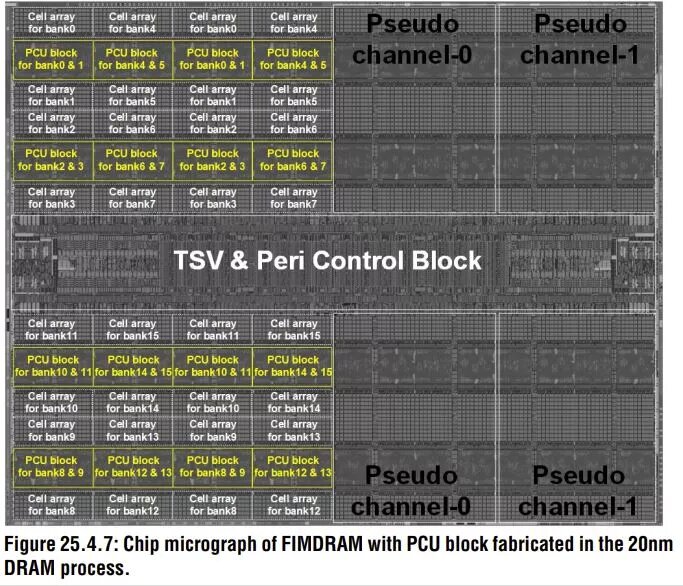

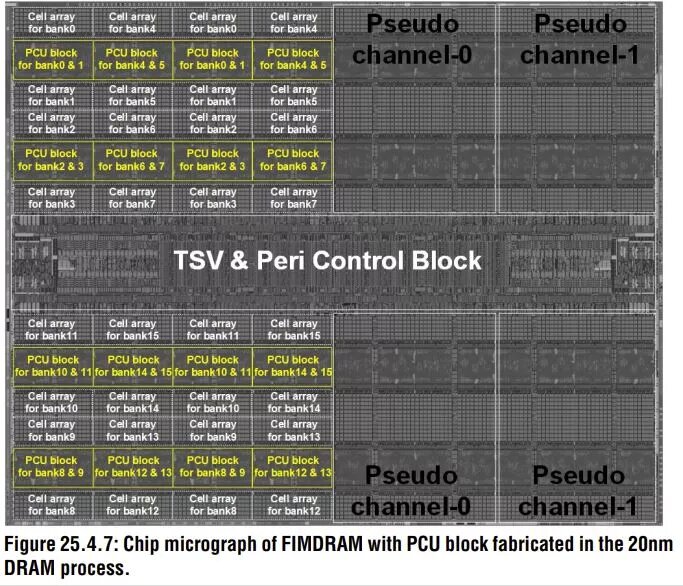

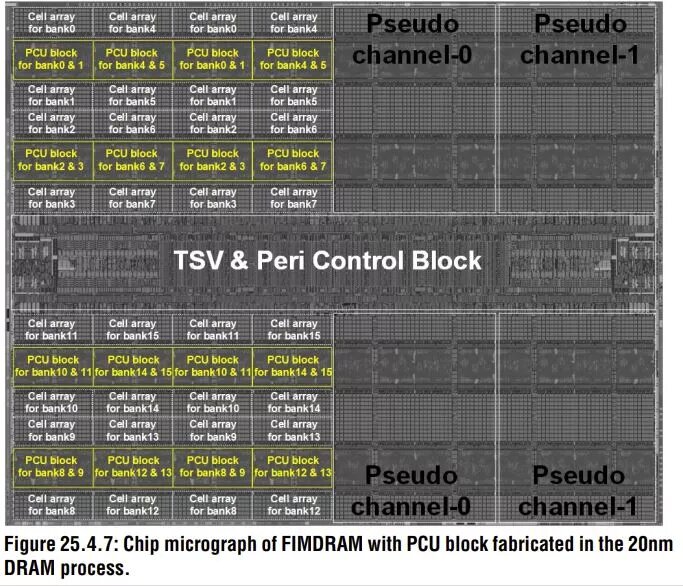

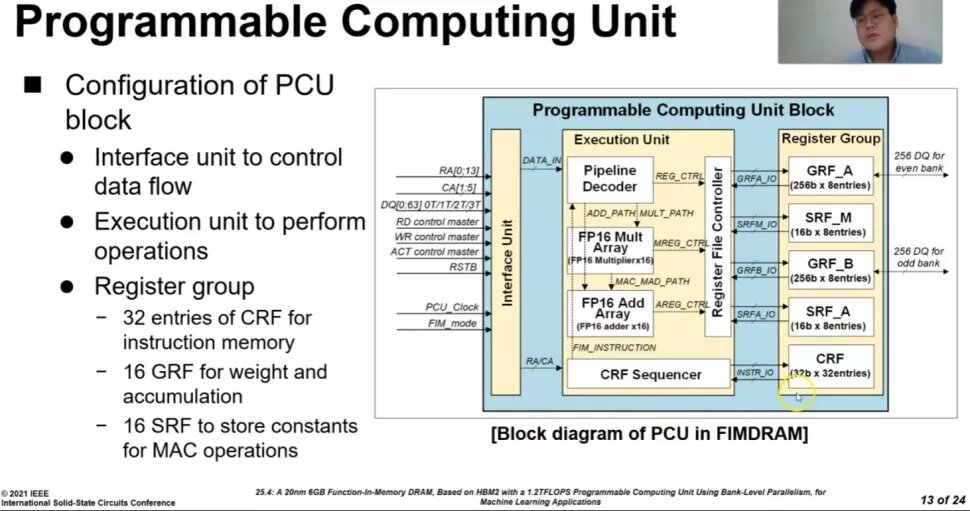

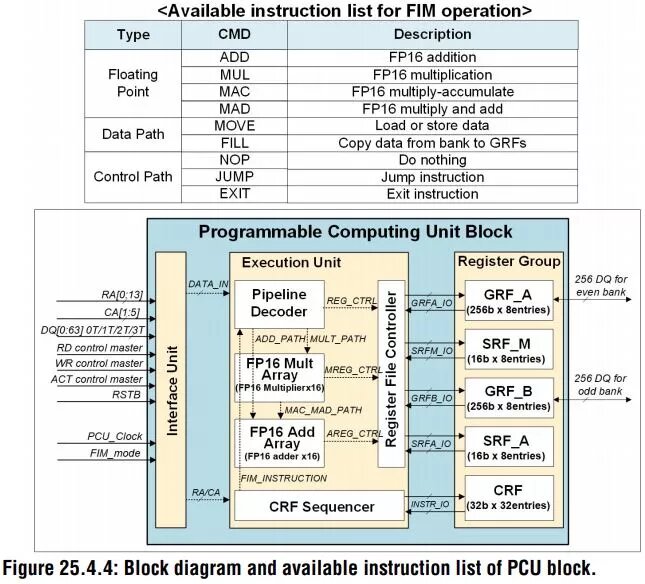

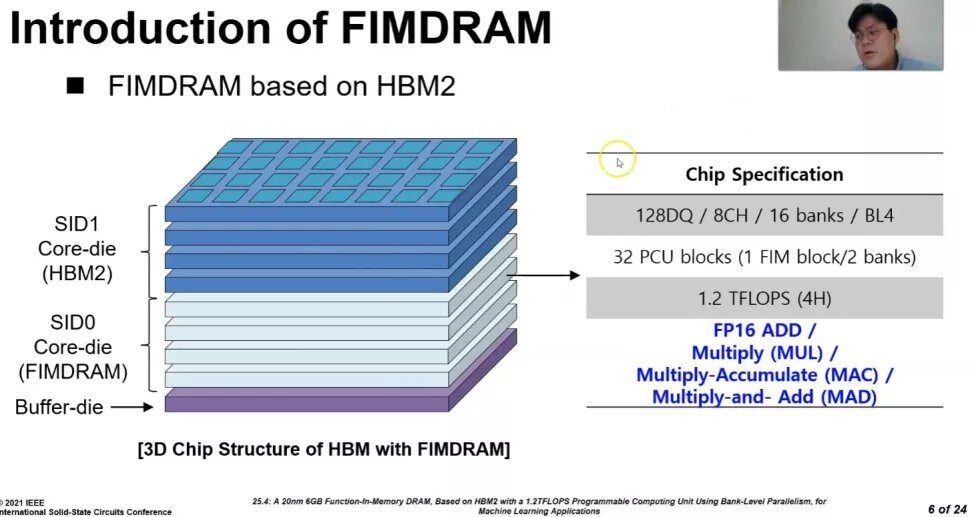

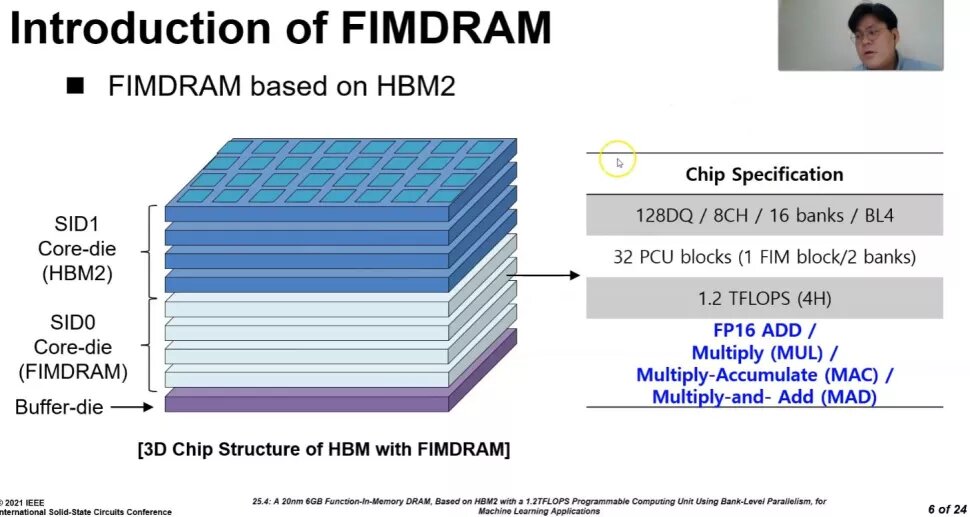

Samsung beschreibt die Technologie als „Function-In Memory DRAM“ (FIMDRAM) und das fertige Produkt als HBM-PIM (Processing-In-Memory). Die wesentliche Neuheit dabei ist nicht nur eine Programmable Computing Unit (PCU), sondern direkt deren 32 Stück pro HBM-Die. Damit wird der Speicherchip in die Lage versetzt, neben dem klassischen Speichermodus als zweite Möglichkeit über ganz normale DRAM-Befehle auch FP16-Operationen auszuführen.

Dabei zielt das System natürlich auf die Berechnungen, die sehr stark von Speicherbandbreite abhängig sind respektive profitieren können. Samsung nennt so „Inference“ und Spracherkennung als Aufgabengebiete. Die PCUs sind dabei frei programmierbar ähnlich einem FPGA, jedoch mit stark reduziertem Befehlssatz. Sie takten zurzeit mit 300 MHz, was eine Rechenleistung von 1,2 TFLOPS pro HBM-PIM-Die ergibt.

-

HBM-Chip mit PCU (Bild: Samsung via THG)

Bild 1 von 3

HBM-Chip mit PCU

PCU-Möglichkeiten im HBM

PCU-Möglichkeiten im HBM

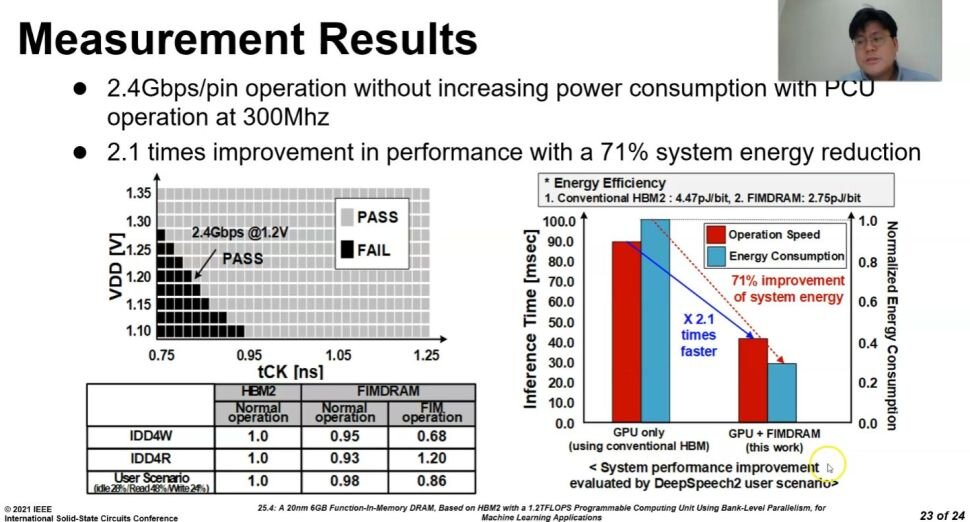

Doppelte Leistung bei 70 Prozent weniger Energie

Arbeitet eine GPU auf einer Beschleunigerkarte mit dem neuem HBM-PIM zusammen, soll mehr als die doppelte Leistung zur Verfügung stehen und gleichzeitig der Energiebedarf um 71 Prozent sinken, zeigt Samsung am Beispiel Deep Speech 2. Das Energiesparen kommt dabei vermutlich hauptsächlich durch die gute Speicheranbindung und Parallelisierung bei geringen Taktraten zustande, eine niedrig getaktete GPU mit gleicher Speicheranbindung würde wahrscheinlich ähnliche Ergebnisse liefern.

Doppelt so schnell und 70 Prozent weniger Energie (Bild: Samsung via THG)

Doppelt so schnell und 70 Prozent weniger Energie (Bild: Samsung via THG) Die PCUs nehmen dabei aber 50 Prozent der Kapazität des Dies in Beschlag, aus dem eigentlich 8 Gigabit großem HBM-Speicher wird nur noch ein 4 Gigabit großer. Durch angepasste Stapel ist der finale Chip am Ende aber immerhin noch 6 Gigabyte groß, klassischer HBM2 ist mit 8 GByte unterwegs. Denn Samsung trickst hier ein wenig: Man mischt vier klassische HBM-Dies und vier mit HBM inklusive PCU. Einige Fragen wie beispielsweise zur Kühlung sind aktuell nicht geklärt, die hohe Leistung der neuen Chips dürfte, wie bereits bei normalem HBM, entsprechend hohe Temperaturen hervorrufen.

-

Vier normale HBM-Dies plus vier HBM mit PCU bilden ein Chip (Bild: Samsung via THG)

Bild 1 von 2

Vier normale HBM-Dies plus vier HBM mit PCU bilden ein Chip

Vergleich der Speicherchips

Testballon heute, mit HBM3 in Zukunft

HBM-PIM auf Basis von HBM2 dürfte in dieser Phase primär ein Testballon von Samsung sein. Samsung erklärte, dass man mit Herstellern zusammenarbeite und erste AI-Beschleuniger teste. Auf der Roadmap ist aber bereits die Weiterentwicklung mit HBM3 zugegen, einen Termin dafür nennt der Hersteller jetzt aber noch nicht. Angesichts der bereits sehr lange andauernden Entwicklung von HBM3 und den ersten Berichten dazu bereits vor mehr als fünf Jahren, dürften wohl noch einige weitere Jahre ins Land ziehen, bis HBM3 mit Processing-In-Memory verfügbar wird.