Google Research publiceert informatie over zijn onderzoek naar neurale netwerken. Dat doen ze aan de hand van verschillende soorten plaatjes, zowel door het netwerk te voeden met beeltenissen als andersom: een netwerk leren vormen te maken uit willekeurige ruis en al wat daartussen zit.

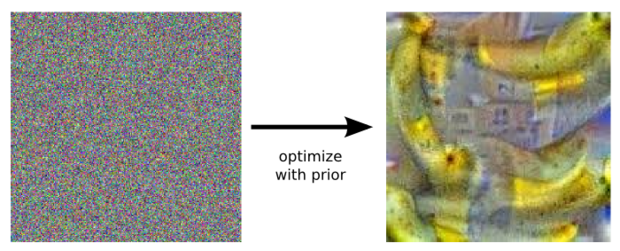

De achterliggende technieken voor neurale netwerken zorgen voor interessante beeltenissen. Het laat zien dat kunstliefhebbers zich in de nabije toekomst misschien moeten gaan afvragen of ze naar een door een mens vervaardigd werk kijken of naar een werk bedacht door een paar sets kunstmatige neuronen.

Een naam voor de nieuwe kunststroming is er in ieder geval al: inceptionism. De stroming bestaat uit neurale netwerken die getraind worden door miljoenen plaatjes te analyseren, waarna geleidelijk de netwerkparameters worden aangepast totdat er de classificatie uitkomt die de onderzoekers willen. Elk plaatje wordt eerst in de input-laag gestopt, waarna die laag met de volgende laag ‘praat’ totdat de output-laag is bereikt. Het ‘antwoord’ van het netwerk komt uit de output-laag.

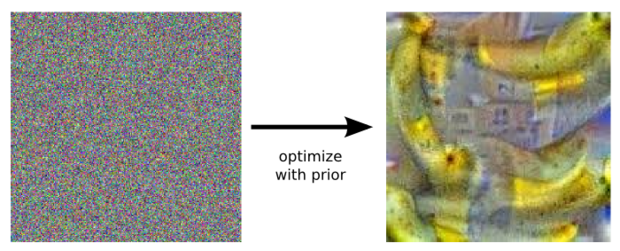

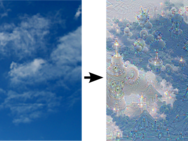

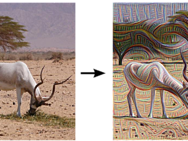

De uitdaging voor de onderzoekers is om te begrijpen wat er precies in elke laag plaatsvindt. Er is op dit moment niet bekend wat elke laag detecteert. Het kan bijvoorbeeld zo zijn dat een eerste laag kijkt naar hoeken en randen, de daaropvolgende lagen de basisvormen interpreteren, zoals een deur of een dier en dat de laatste lagen actief worden bij nog complexere vormen, zoals hele gebouwen. Om er achter te komen wat er in het netwerk gebeurt, kan de procedure omgedraaid worden door bijvoorbeeld te vragen aan het netwerk om zich een plaatje voor te stellen van een banaan vanuit willekeurige ruis, dan wordt het echt interessant.

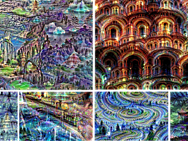

Het team heeft ook testen gehouden met interpretaties waarbij niet van tevoren ingegeven wordt wat er uitgelicht moet worden, maar het netwerk zelf mag beslissen wat er te zien is. Dan wordt een willekeurig plaatje ingeladen en wordt aan een laag van het neurale netwerk gevraagd om uit te lichten wat het netwerk dan detecteert. Omdat elke laag van het neurale netwerk op een andere manier omgaat met abstractie, komen er van alleen simpele streken tot figuren en hele beelden uit. Door een feedback-loop te maken, komen er steeds beter herkenbare plaatjes uit.

Bron: Inception Image Gallery

Uiteindelijk doet Google dit werk natuurlijk niet voor de lol. Het is om te begrijpen en visualiseren hoe neurale netwerken leren moeilijke classificatietaken uit te voeren, hoe netwerkarchitectuur te verbeteren is en wat het netwerk leerde tijdens de training.

Update 22 juni, 11.38: Tweaker H!GHGuY merkt terecht op dat het artikel wel een erg grote versimpeling is van de werkelijkheid. Het artikel is daarop aangepast.